Antonio Gramsci futurista, inteligencia artificial. Generado mediante DALL-E. Imagen recortada.

“Mi conclusión es que el robot tiene sesgo e incluso un estilo. Tiende a ser amable con las figuras públicas e históricas sobre las que es preguntado y, al mismo tiempo, procura ser conciliador. Pero lo más fascinante es que se maneja con los marcos dominantes y en disputa ofreciendo en sus textos una suerte de jerarquía gramsciana.” Pablo Iglesias

Artículo del Doctor por la Universidad Complutense, Pablo Iglesias, publicado por primera vez el 27 defebrero del 2023 en la revista Ctxt.

Mitos de la globalización | por Noam Chomsky

La manipulación del miedo | por Noam Chomsky

Buscamos escritores

Convierte tu manuscrito en realidad. En Editorial Bloghemia te acompañamos en el proceso completo de publicación, desde la edición hasta la distribución.

Por: Pablo Iglesias

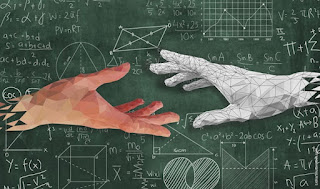

Desde que uno de los papás del cole de mis hijos, profesor universitario de Matemáticas, me empezó a comer la oreja con lo del ChatGPT y el machine learning, duermo peor que Pedro Sánchez en sus grandes momentos. No dejo de probar cosas y compruebo, con gran inquietud, que el amigo robot es capaz de hacer cosas increíbles. Siempre pienso en cómo le explicaría a mis abuelos, que murieron a mediados de los ochenta, el funcionamiento de internet. Tendría que decirles que si el teléfono posibilita que la voz viaje, la red permite que también lo haga el texto, la imagen y el vídeo. Pero no sabría explicarles ChatGPT.

He probado a plantearle preguntas muy difíciles de exámenes imaginarios de Ciencia Política que el amigo robot resuelve, a mi juicio, con mejores resultados que los que obtendrían estudiantes universitarios de Ciencias Sociales con acceso durante el examen a bibliografía académica.

Leí ayer el artículo que Sebastiaan Faber hizo en CTXT a propósito de ChatGPT en el que revelaba la enorme sensatez del robot a la hora de proponer metodologías docentes y pedagógicas: “Es importante que los estudiantes hagan tareas que sean difíciles de automatizar, como presentaciones orales o debates en clase; tareas de redacción que pidan un nivel alto de creatividad o reflexión crítica; exámenes en clase que incluyan componentes de conversación real; proyectos en grupo que requieran que los estudiantes colaboren y se comuniquen en español”. Lo que básicamente nos decía la máquina es que para que los estudiantes demuestren sus competencias tenemos que escucharles sin que, durante su exposición, puedan contar con la prótesis cerebral que implica tener un dispositivo conectado a internet.

En el texto de Faber se explicaban además algunos fallos extraños de un robot capaz de atribuir erróneamente artículos académicos a autores que no los habían escrito. Faber preguntaba por las razones de un fallo tan improbable en un ser humano y el robot respondía algo que me fascinó: “Soy un modelo lingüístico, a veces cometo errores en mis respuestas”, y Faber citaba a un tal Tim Harford que explicaba que ChatGPT “tiene un modelo del tipo de cosas que la gente tiende a escribir. Esto explica por qué suena tan increíblemente creíble. Pero también explica por qué le puede costar dar respuestas verdaderas, incluso ante preguntas relativamente directas”. La herramienta, concluye, “afirma muchas cosas que son verdad”. Pero “solo las dice como producto secundario. Lo que ha aprendido es a parecer creíble”. Fascinante.

No sé qué es exactamente el “modelo lingüístico” al que se refiere ChatGPT pero he seguido jugando con el robot. Le he pedido que escriba un soneto sobre mí y otro sobre Mariano Rajoy, le he pedido un análisis sobre la implicación del gobierno de los EE.UU. en el golpe contra Salvador Allende, le he pedido que escriba un artículo periodístico sobre la credibilidad de los medios de comunicación, le he preguntado por la autoría de los ataques a los oleoductos Nord Stream, también sobre el concepto de subsunción real en Marx, sobre el análisis de sistemas-mundo y la gobernanza global, sobre los pactos de la Moncloa y también sobre la desamortización de Mendizábal…

Mi conclusión es que el robot tiene sesgo e incluso un estilo. Tiende a ser amable con las figuras públicas e históricas sobre las que es preguntado y, al mismo tiempo, procura ser conciliador. Pero lo más fascinante es que se maneja con los marcos dominantes y en disputa ofreciendo en sus textos una suerte de jerarquía gramsciana.

El artículo sobre la credibilidad de los medios que le pedí es muy interesante. El robot asume en su artículo que la crisis de credibilidad de los medios es una realidad y que eso es malo para la democracia y para la sociedad. Sin embargo, la principal causa de esa crisis de credibilidad de los medios sería, en “su opinión”, la polarización política que nuestro robot-periodista atribuye a “los políticos” que utilizarían los medios para difundir información falsa o distorsionada.

Este es, sin duda, el marco que interesaría a los periodistas y a los propios medios dominantes; atribuir sus problemas de credibilidad a la polarización y a “los políticos”; qué malo es el ruido y qué mala es la polarización y cuánto dinero se ahorrarían en asesores algunas figuras políticas cuando ChatGPT les ofrece gratis los mismos consejos.

Sin embargo, el artículo continúa y aparecen nuevos marcos muy diferentes al primero, como la proliferación de noticias falsas y una recomendación interesante del robot-periodista: que los medios deberían ser transparentes sobre su financiación y sus fuentes de información. El robot señala también la importancia de lo que llama “alfabetización mediática” de los ciudadanos.

Desconozco como funciona ChatGPT en tanto que modelo lingüístico, pero deduzco que jerarquiza los temas y las conversaciones a las que tiene acceso a través de internet. Es como si sus respuestas fueran el resultado de una batalla ideológica, una batalla de marcos. ¿Cabría imaginar robots con acceso a los mismos recursos que ChatGPT pero con un sesgo ideológico más concreto o una voluntad política más concreta? ¿Lucha por la hegemonía entre replicantes? “Yo he visto cosas que vosotros no creeríais. Atacar naves en llamas más allá de Orión. He visto rayos-C brillar en la oscuridad cerca de la Puerta de Tannhäuser. Todos esos momentos se perderán en el tiempo, como lágrimas en la lluvia”. Tela.

Publica un artículo

Comparte tu voz con nuestra comunidad. Publica tus artículos en nuestra revista y conecta con lectores apasionados por la cultura, arte y literatura.

ENVIAR ARTÍCULOSuscríbete a nuestro Boletín

Recibe en tu correo nuestros últimos artículos, reseñas y escritos de nuestros colaboradores.